-

**请描述该需求尝试解决的问题**

启动crawlab时会默认创建ssh 私钥,如果用户已有同名私钥则会请求覆盖私钥。

**请描述您认为可行的解决方案**

由于是初次使用,不知道生成的私钥会用在什么功能。

是否可以生成如id_rsa_crawlab的文件名然后用ssh config文件进行管理?

-

不能使用非crawlab里面mongodb么?

-

scrapy项目上传,爬虫解压的逻辑

正常在本地打包项目,如果进入项目中进行压缩感觉有些反人类的操作

在后台创建文件的目录树:

```shell

└── test2

├── md5.txt

├── scrapy.cfg

└── test2

├── __init__.py

├── __pycache__

│ …

-

**Describe the bug**

按照文档创建scrapy_quotes爬虫,上传后运行,报 “AttributeError: module 'OpenSSL.SSL' has no attribute 'SSLv3_METHOD'”,粗略查了一下,sslv3已经被废弃,最新的openssl版本已经到了23.2.0。

其他的报错咱也看不懂,请问大佬这种情况如何处理?提前致谢~

…

-

如果在Scrapy中已经写好了自己的数据存储管道时,在settings启动时,可以直接将数据存入到自己的数据库中,例如MySQL、MongoDB。个人认为比使用SDK方便

-

-

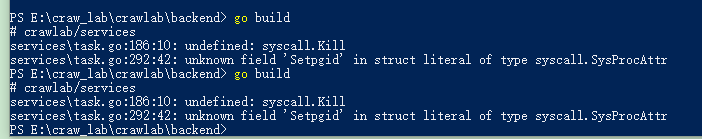

# crawlab/services

services\task.go:186:10: undefined: syscall.Kill

services\task.go:292:…

-

I'm actually using crawlab scheduler but I can't find a way to make jobs in continuous ( for one spider run a job after previous job is finished ).

-

**Describe the bug**

I followed official [Quick Tutorial](https://docs.crawlab.cn/en/guide/basic-tutorial/#create-spider), and encountered the error `AttributeError: module 'lib' has no attribute 'Op…

-

/usr/local/lib/python3.8/dist-packages/crawlab/core/client.py文件190行

@staticmethod

def settings(directory=None):

if directory is None:

directory = os.path.abspath(os.c…