과제 제출 예시 내용은 꼭 아래처럼 할 필요 없이 조별로 자유롭게 쓰시면 됩니다!

0조

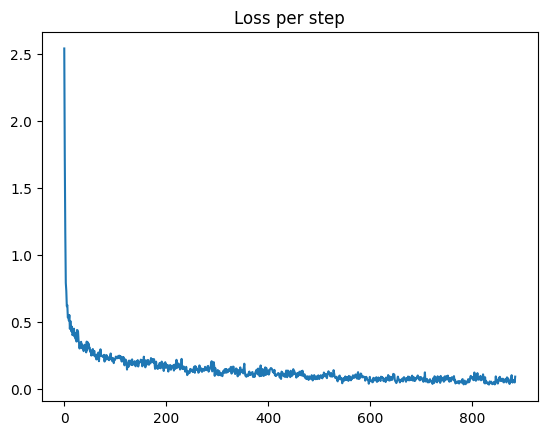

Fashion MNIST 학습 결과

1. Feed forward network(3주차 과제 결과)

- Train accuarcy: 00%

- Test accuracy: 00%

2. CNN + MaxPool

- Train accuarcy: 00%

- Test accuracy: 00%

4. MobileNet(with pretrained weights)

- Train accuarcy: 00%

- Test accuracy: 00%

5. MobileNet(without pretrained weights)

- Train accuarcy: 00%

- Test accuracy: 00%

결과 분석

- 학습 결과 분류 성능이 가장 뛰어난 모델 아키텍쳐는 어떤 것이었나요?

- MobileNet 구조에 사전 학습된 파라미터를 불러오는 것은 어떤 결과를 가져왔나요?

- 기타 분류 성능을 높이기 위한 여러 도전들(하이퍼파라미터 튜닝 등)이 있다면 공유해주세요~!!

90%라는 좋은 test accuracy를 얻을 수 있었습니다.

90%라는 좋은 test accuracy를 얻을 수 있었습니다.

ng)

미리 학습된 가중치를 사용하니 CNN의 결과보다 더욱 좋은 결과를 얻을 수 있었습니다.

ng)

미리 학습된 가중치를 사용하니 CNN의 결과보다 더욱 좋은 결과를 얻을 수 있었습니다.

가중치를 없이 학습을 한 모델은 과적합되어 낮은 test accuracy를 보였습니다.

가중치를 없이 학습을 한 모델은 과적합되어 낮은 test accuracy를 보였습니다.

네 번째 과제: 최신 모델과 Transfer Learning의 효과 분석

회합 자료 링크: https://github.com/HanyangTechAI/2023-Deep-Learning-Study/issues/1#issuecomment-1497256534

Colab Python 노트북을 사용한 모델 학습 코드 구성하기

fashion_mnist_cnn.ipynb

Step 1. 예시 노트북을 실행해보며 CNN 모델로 Fashion MNIST 튜닝하기

Step 2. MobileNet의 Fashion MNIST 분류 문제 transfer learning 효과 분석