DragDiffusion

- project

- arxiv

- code

- Title: DragDiffusion: Harnessing Diffusion Models for Interactive Point-based Image Editing

- Institution: ByteDance Inc.

TL;DR

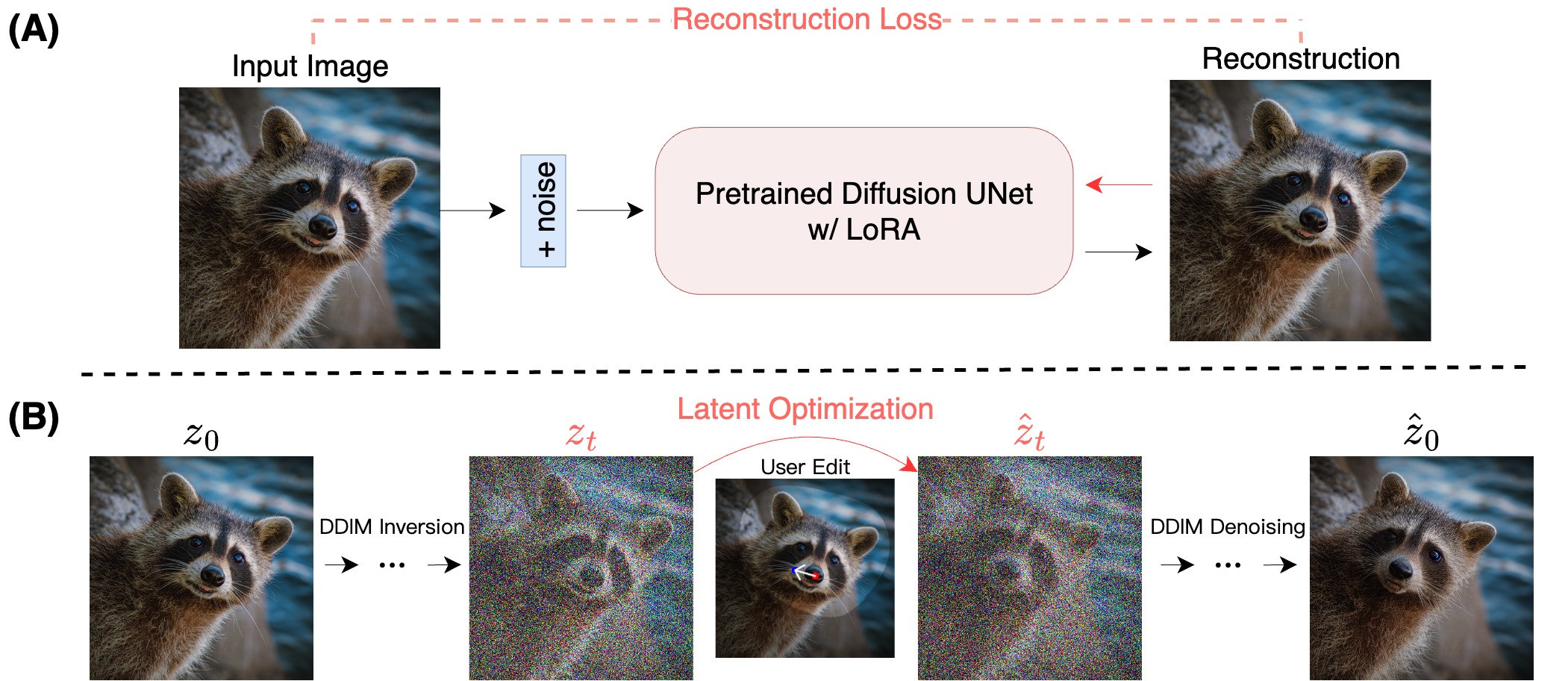

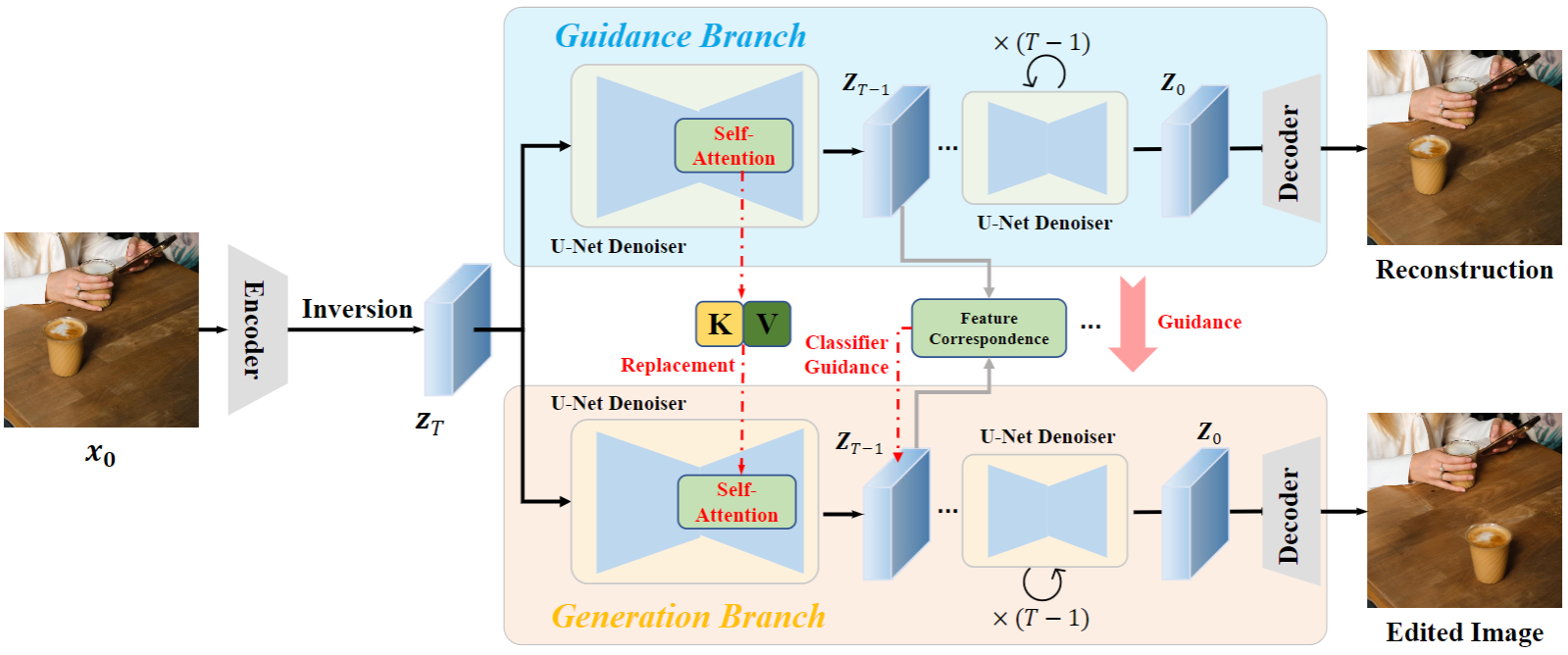

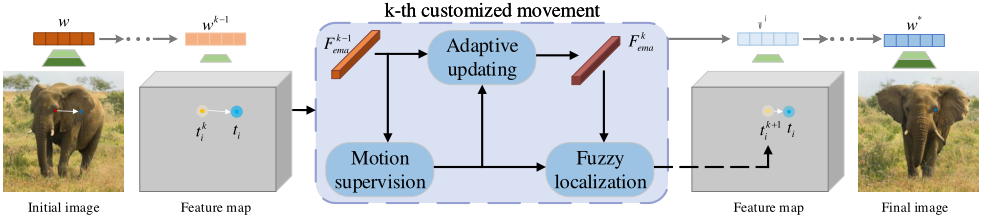

- 把DragGAN的操作(motion supervision+point tracking)拿到了diffusion model的U-Net Decoder解码时的feature map上去做(DragGAN是在GAN的feature map上做的)

- 因为drag操作会导致object/style shift(拖动之后猫变成狗),因此需要先用Drag之前的图训一个LoRA,然后再Drag

DragGAN

TL;DR

baseline

Related work

pipeline

思考