Unsupervised Semantic Correspondence Using Stable Diffusion

下面是Claude给出的总结:

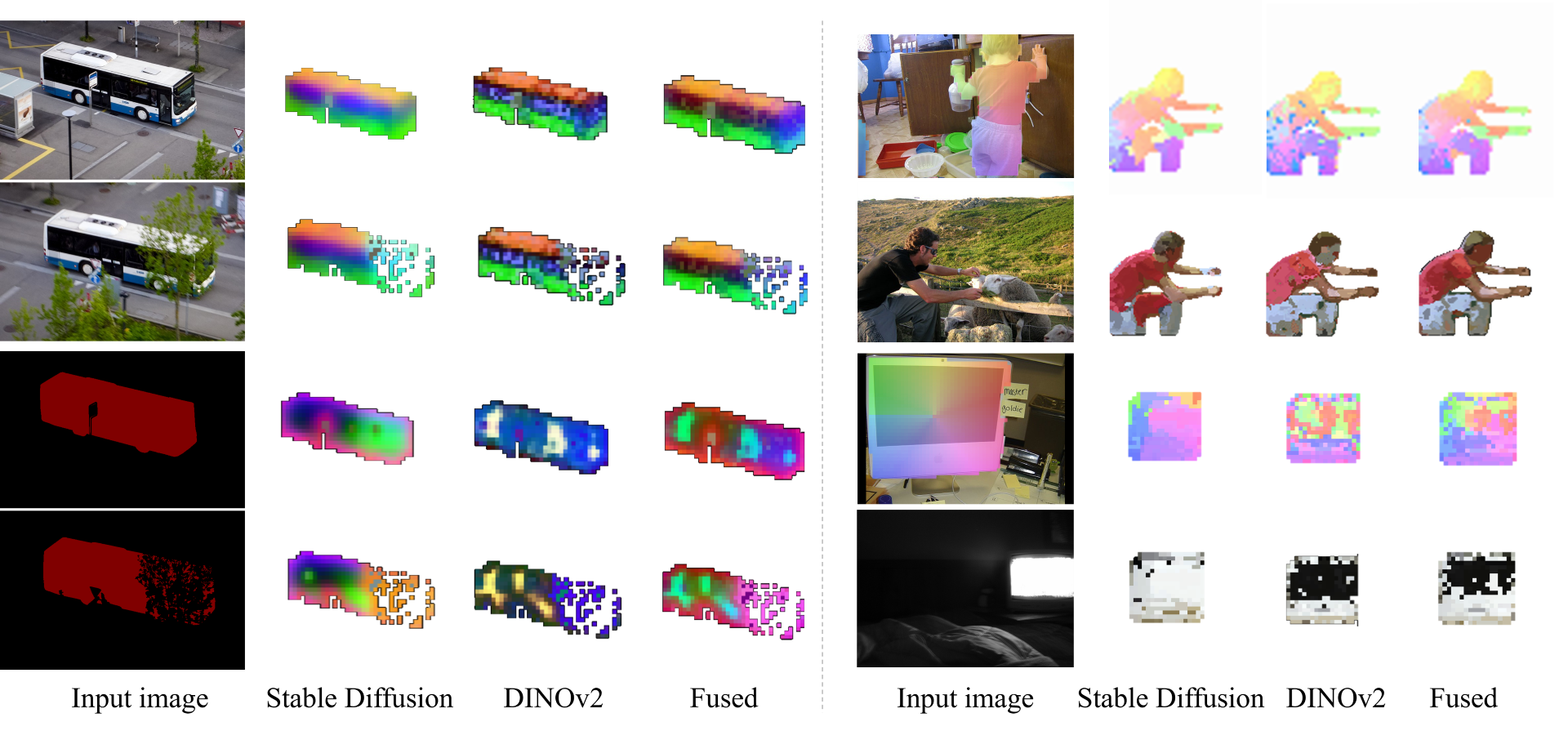

和DIFT的区别和联系

- 本文通过优化文本embedding,DIFT直接利用模型中间特征。

- 本文使用attention map获取对应的点,DIFT通过特征匹配获得。

- 两篇文章都利用了图像diffusion模型内含的丰富语义知识,不需要额外训练。

- 这篇文章进行了更全面的评估,在多个数据集和对应任务上证明了效果。

- 两篇文章都显示仅利用预训练模型就可以达到很强的语义对应效果,证明模型隐含这些知识。

- 这篇文章提出的DIFT特征提取方法更直接简单,也更适合实际应用。

总体来说,两篇文章思路相关但技术不同,验证和展示了diffusion模型的语义对应学习能力,为相关任务提供了有效和实用的解决方案。

解决的问题

这篇文章主要解决的是图像语义对应问题,也就是在不同图像中找到语义上对应的点。

具体来说,文章解决的是以下问题:

- 给定一对图像(源图像和目标图像)以及源图像中的某一个查询点,找到目标图像中与该查询点语义对应(语义相似)的点。

- 目前找到语义对应点主要依赖监督信息,需要大量带人工注释的图像对进行训练。文章研究如何在完全无监督的情况下找到语义对应。

- 现有的语义对应方法过于依赖特定的数据集和任务,希望找到一个更通用、可迁移的语义对应框架。

- 现有利用预训练模型提取特征进行语义对应还存在不足,希望能更好地利用预训练模型中的语义知识。

- 目前语义对应任务的无监督方法效果仍然很有限,希望能提出一种高效和可靠的无监督语义对应框架。

- 在标准的语义对应数据集如PF-Willow、CUB-200和SPair-71k上,现有方法效果仍有很大提升空间。

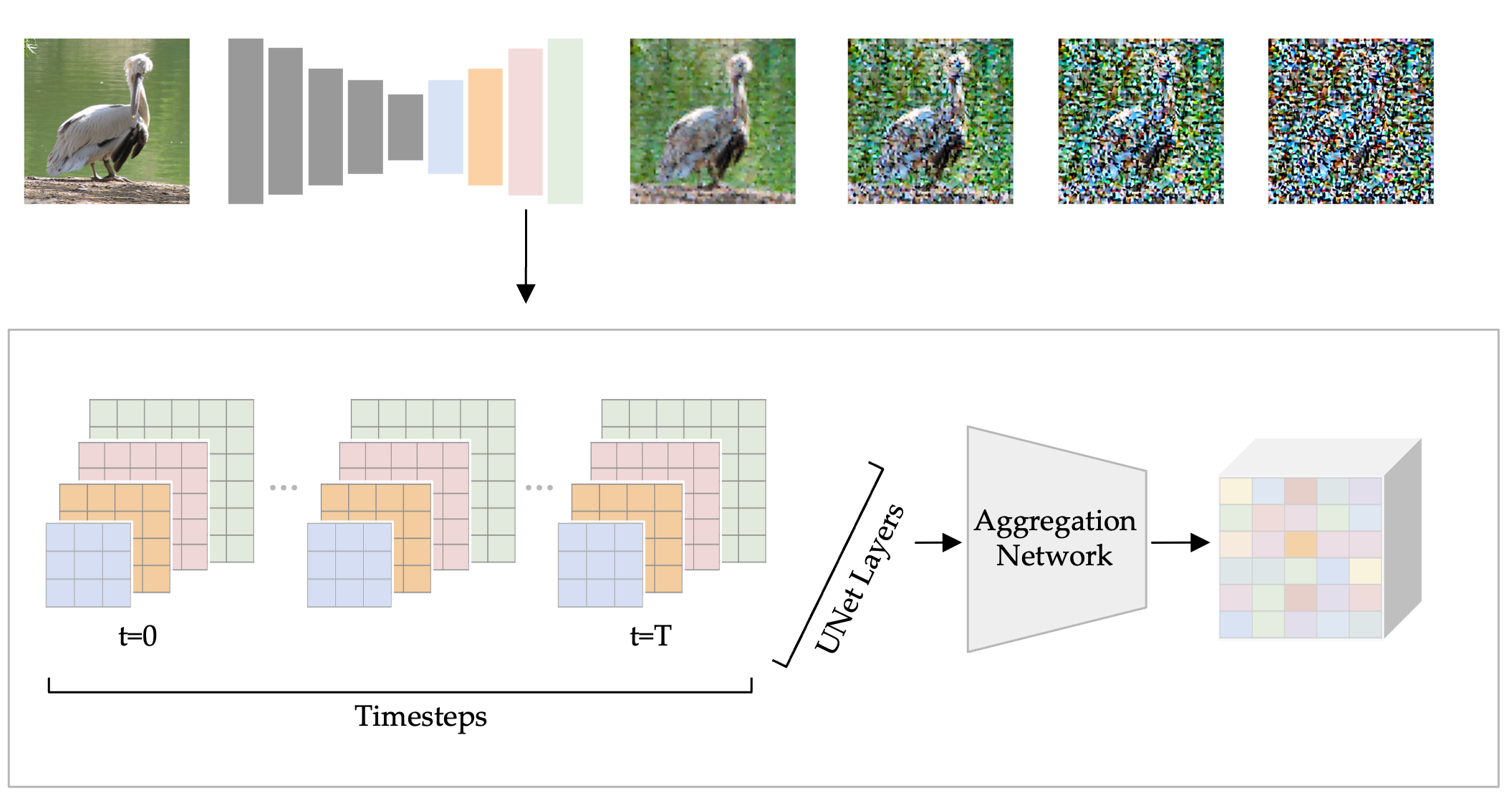

method

具体步骤

本文使用的无监督语义对应方法的具体步骤是:

- 给定一对图像(源图像和目标图像)以及源图像中的一个查询点。

- 使用Stable Diffusion等固定的迁移模型,优化一个文本embedding,使得模型中的attention map在源图像中凸显查询点。

- 重复随机初始化并优化文本embedding多次,获得多个embedding。

- 在源图像上使用随机裁剪数据增强,避免过拟合。

- 将优化得到的embedding应用到目标图像上,分别生成attention map。

- 对目标图像也使用随机裁剪,融合不同embedding和不同裁剪产生的attention map。

- 在融合的attention map上取最大值点作为目标图像中的语义对应点。

- 使用模型多层的attention map构建金字塔表示,增强鲁棒性。

- 不需要对语义对应任务进行任何自定义训练,直接利用固定的预训练迁移模型。

综上,本文使用固定迁移模型、优化embedding、attention map及数据增强来完成从源图像查询点到目标图像对应点的语义匹配,整个流程无需人工标注数据和模型微调。

优缺点

本文的主要优点如下:

- 完全无监督,不需要人工标注的数据进行训练,具有很好的可扩展性。

- 直接利用预训练好的模型,没有引入新的参数,避免过拟合。

- 提出了有效的框架和技术细节,如多次优化、随机裁剪、多层attention等。

- 在多个标准数据集上优于其他无监督和弱监督方法,效果可靠。

- 思路新颖,证明了预训练模型中包含丰富的语义知识可被挖掘。

- 可迁移到很多下游任务,如对齐数据、生成3D模型等。

缺点:

- 计算量较大,inference时间较长。

- 对称物体的语义对应效果较差。

- 需要选择合适的超参数。

- 对数据集分布变化的鲁棒性有待验证。

- 还需进一步提升在更多数据集上的泛化能力。

- 理论分析不够深入。

整体来说,本文从无监督语义对应角度出发,方法新颖高效,但计算量是主要限制,理论分析还有提升空间。后续可考虑加速优化,改进对称性建模,增强模型对分布变化的适应能力。

DIFT

overview

diffusion model

method

问题

疑问

论文discussion

细节

思考