비유는 오해를 불러일으킬 수 있습니다, 하지만.... 쉽게 말해보려면 아래처럼 말해볼 수도 있을 것 같습니다.

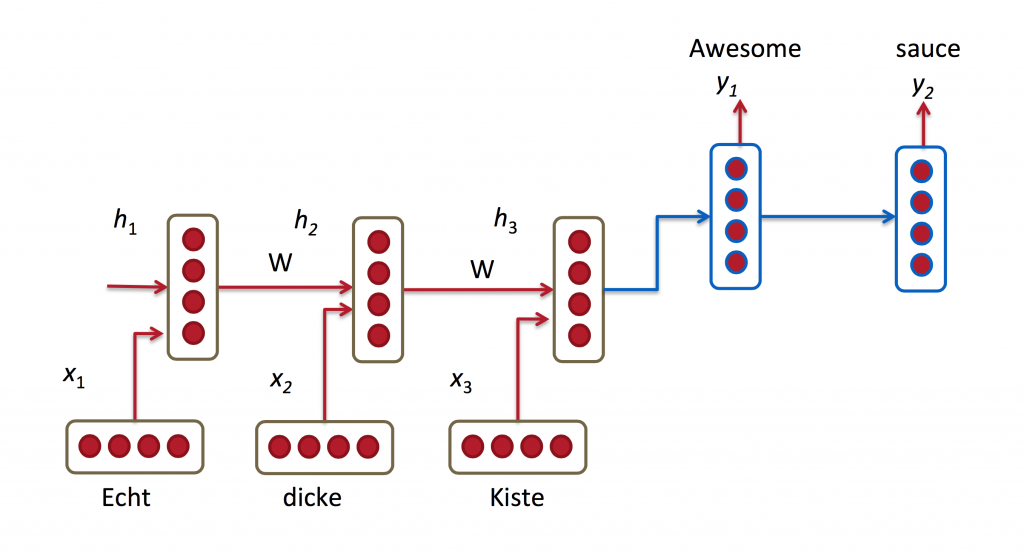

RNN은 아래와 같이 동작할 수 있습니다. 최대한 단순하게만 설명해보겠습니다.

사람1, 사람2, 사람3, 사람4, 사람5, 사람6, 사람7 이 순서대로 서있습니다.

사람1은 해리포터 1권을 읽습니다. --> 사람2에게 내용을 요약해줍니다.

사람2는 해리포터 2권을 읽습니다. 또한 사람1에게 해리포터 1권 내용을 들었습니다. --> 사람3에게, 사람1에게 들은 내용과 해리포터 2권 내용을 한꺼번에 요약해줍니다.

...

사람 5는 해리포터 5권을 읽습니다. 또한 사람4에게서, 해리포터 4권내용과 사람3의 이야기를 요약한 내용을 들었습니다. --> 사람6에게 사람4에게 들은 내용과 해리포터 5권 내용을 한꺼번에 요약해줍니다.

...

사람 7은 사람6에게서 들은내용과 해리포터7권을 종합하여. 해리포터가 재밌다 / 재미없다를 판단하는데 도움을 줄 정보를 말합니다.

중1 학생입니다 mlp cnn 요런건 중1수학실력으로도 어거지로 이해 했지만 rnn이랑 lstm은 많은 동영상과 구글링을 해봐도 이해하기 쉽지가 않네요 쉽게 이해시켜주실분 계신가여