LSTM: intuition

sentiment analysis를 예시로, 한번 다음과 같은 사고 실험을 해보자.

재미있는 / 재미없는 영화

최근에 본 영화중에, 보고나서 정말 재미있었던, 혹은 재미없었던 영화가 있는가?

지금 그런 영화를 떠올려보고, 스스로 왜 그 영화를 긍정적 /부정적으로 평가했는지를 한번 생각해보자.

"영화가 재미있었다/재미없었다"라는 판단을 하기위해 영화의 모든 줄거리를 떠올려야 했는가? 남주와 여주가 사랑에 빠지고, 관계에 위기가 오고, 이후에는 다시 만났으며... 등등. 굳이 그런 세세한 내용을 다 상기하지 않아도(애초에 가능하지도 않다), 우리는 영화의 줄거리에 대한 전반적인 기억을 바탕으로 영화가 재미있었다, 재미 없었다 라고 판단할 수 있다.

영화에 대한 내용을 떠올릴 수 있을 정도의 장기기억은 필요하지만, 그 장기기억이 영화 그 자체일 필요는 없다. 재미있었다, 나쁘다를 판단할 수 있는 기억만 장기기억에 남아 있으면 충분하다.

즉, 단기기억과 함께 장기기억도 필요하지만, 우리의 뇌는 어떠한 일을 수행하기위해 정말로 필수적인 기억만을 장기기억에 남기며, 필요없는 기억은 장기기억에서 지운다.

그게 LSTM과 무슨 상관?

이러한 "필요한 기억은 저장하고 필요없는 기억은 장기기억에서 지운다"라는 생각이 LSTM의 기본적인 작동원리를 설명하는 생각.

| 모델 | 예를 들면 이런 것 |

|---|---|

| RNN |  |

| LSTM |  |

LSTM의 구조

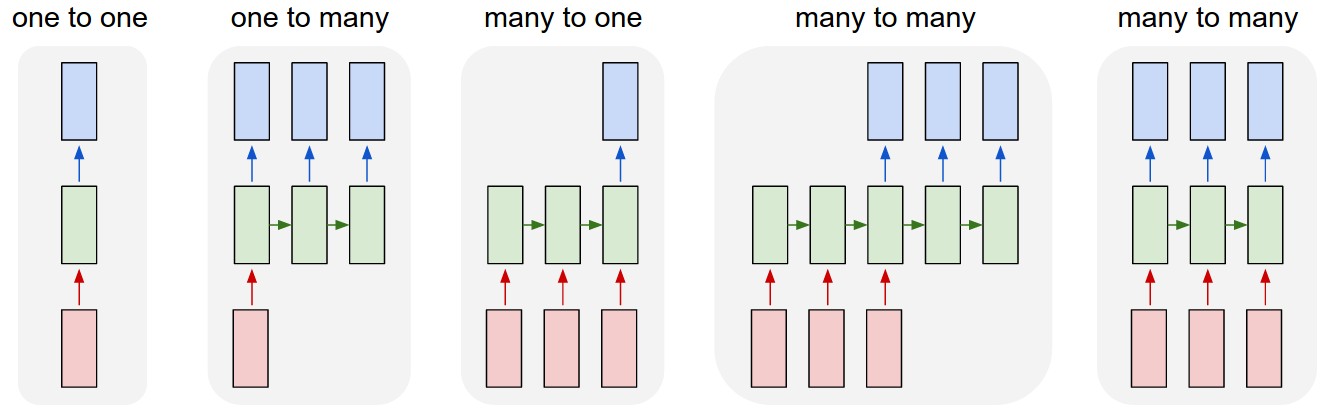

시작부터 내부를 너무 자세하게 들여다보기 전에, 일단 최상위 abstraction에서 RNN과 어떤 차이점이 있는지부터 살펴보자.

From the book NLP in Action:

| RNN (unrolled) | LSTM (unrolled) |

|---|---|

chapt 8, Loopy (recurrent) neural networks (RNNs), pg252 |

chapt 9, Improving retention with long short-term memory networks, pg 227 |

RNN과의 차이점은 크게 두가지.

- hidden layer 와 함께 memory state (날코딩 책에서 "상태벡터"라고 부르는 것)가 생겼다. 후술하겠지만, 이 memory state가 "Long-term memory"역할을 한다.

- hidden layer의 내부구조가 다르다. 아래 그림에서 볼 수 있듯이, 4가지의 새로운 장치가 추가되었다. 그리고 그 중 3개는 각각 들어오는 정보를 선택적으로 필터링하는 역할.

그렇다면 LSTM의 hidden layer 속은 어떻게 다른걸까?

| LSTM 셀의 기본구조 |

|---|

|

처음 보면 굉장히 복잡하게 생겼다. 하지만 RNN셀과의 차이점과, 내부 장치 4개의 역할을 이해를 하면, 생각보다 간단하다.

먼저 RNN셀과 비교를 해보면서 LSTM은 RNN과 무엇이 다른지 살펴보자.

| .. | RNN | LSTM |

|---|---|---|

| 구조 |  |

|

| 입력 | h_t-1concatx_t |

h_t-1concatx_t, 그리고 이전 시간대까지의 장기기억을 담당하는 c_t-1 |

| 출력 | h_t(현 시간대까지의 단기기억만 생성) |

h_t혹은 c_t (현 시간대까지의 단기기억, 장기기억 둘다 생성) |

| "장치"의 개수 | 1개 per memory cell | 4개 per memory cell |

| 단기기억 생성 | h_t를 출력하는 FC가 존재 |

3번째 장치가 동일한 역할을 함. (input block) |

| 장기기억 생성 | 없음. 모든 단기기억은 여러 시간대의 FC를 거치면서 흐릿해짐(vanishing gradient) | 그 어떠한 FC도 거치지 않는 장기기억의 "컨베이어 벨트"가 존재. 게이트들에 의해 정보가 조금씩 변형되기는 하지만, FC를 거치지 않기 때문에 시간대가 길어져도 vanishing gradient로 인한 정보 손실 위험이 없음 |

구조적인 차이점은 그러하다.

저 못생긴 그림을 자세히 보면, 성분곱셈이 3군데 있는 것을 알 수 있다. 그리고 이 연산은 반드시 sigmoid를 activation으로 하는 레이어 다음에 따라온다. 이는 0또는 1에 가까운 값을 출력하는 sigmoid 함수가 필요한 기억만 선택적으로 가져가는 일종의 필터, 혹은 "게이트" (albeit continuous)로 쓰이는데, 그렇게 쓸 수 있는 방법이 성분곱셈이기 때문이다.

그렇게 쓰이는 장치 3개를 좀 더 자세히 들여다 보자.

| 게이트 | 참고 그림 | 역할 |

|---|---|---|

| forget gate |  |

과거의 단기기억 & 현재에 대한 기억을 바탕으로, 장기기억 벡터에서 필요가 없다고 판단되는 성분은 시그모이드 출력값을 0에 가깝게 조절해, 해당 장기기억을 지운다. |

| input gate |  |

과거의 단기기억 & 현재에 대한 기억을 바탕으로, input block에서 막 생성된 단기기억 벡터의 성분 중, 장기 기억으로 전환할 가치가 있는 성분만 시그모이드 출력값을 1에 가깝게 조절해, 해당 단기기억을 장기기억으로 전환한다. ("전환" = 성분 덧셈 to c_t-1) |

| output gate |  |

과거의 단기기억 & 현재에 대한 기억을 바탕으로, 장기기억 벡터의 성분 중, 다음 시간대의 단기기억으로 쓸만한 성분만 시그모이드 출력값을 1에 가깝게 조절해, 해당 장기기억을 다음 시간대의 단기기억으로 사용한다. |

즉, 성분곰셈이 이루어지는 구간이, 기억이 잊혀지거나 더해지는 구간으로 볼 수 있다. 그렇게 기억의 흐름을 통제하는 역할을 한다는 점에서, 위 3개의 장치를 게이트라고 부르는 것.

LSTM: intuition

LSTM의 구조

장치1: 망각 게이트

장치2: 입력 게이트

장치3: 입력 블록

장치4: 출력 게이트

상태벡터와 순환 벡터 값의 결정

LSTM계층의 출력

LSTM파라미터 구성