- Docker Desktop

- lima: https://github.com/lima-vm/lima

- Mac で Linux VM を動かす

- containerd for Mac

- Podman: https://podman.io/

- daemonless container engine

- nerdctl: https://github.com/containerd/nerdctl

- Docker-compatible CLI for containerd, with support for Compose

- docker

- docker-engine

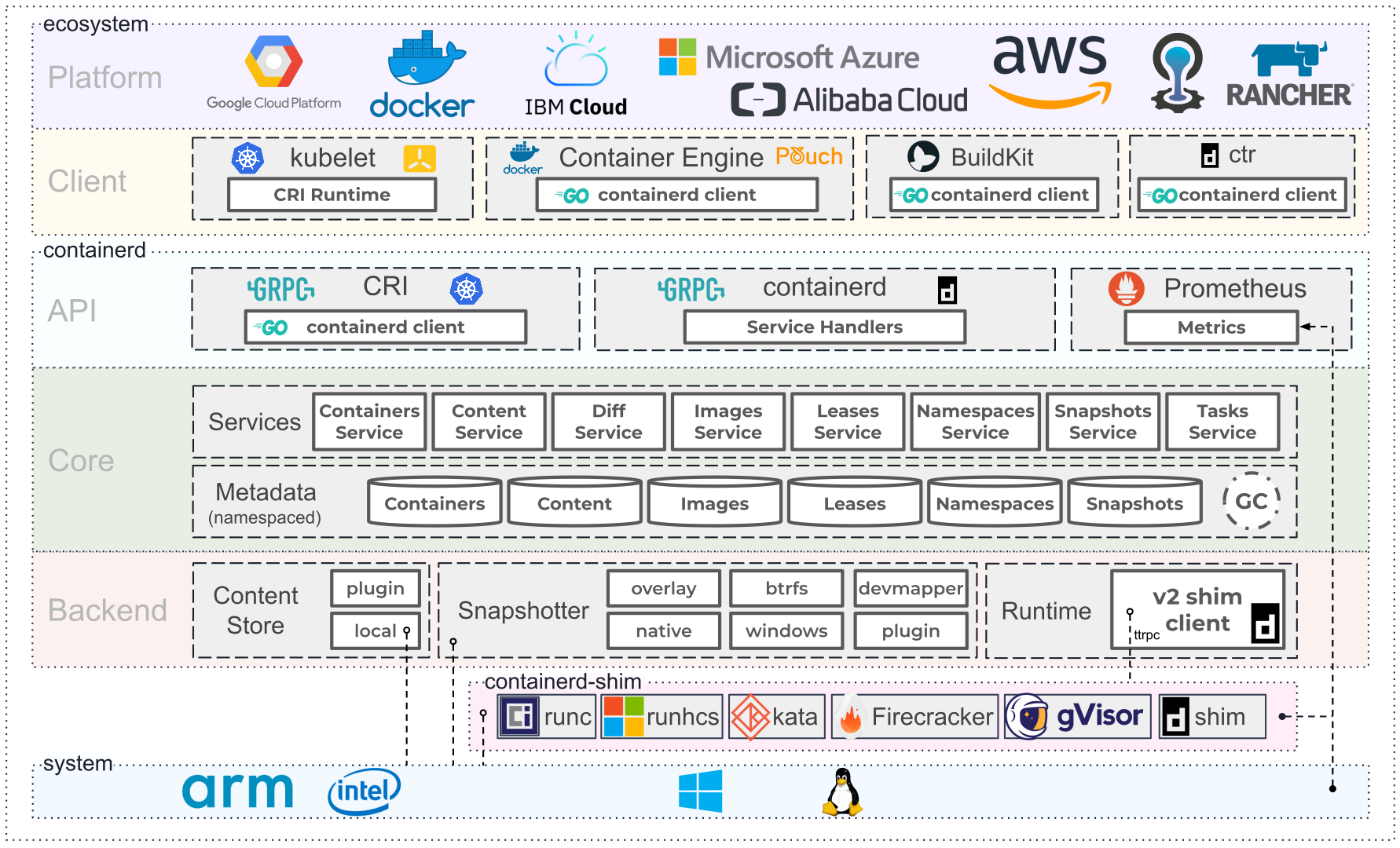

- containerd: https://containerd.io/

- CNCF graduated project

- minikube: https://minikube.sigs.k8s.io/docs/

Mac で普段開発していて、 Docker を使うときは Docker for Mac を使ってきた。 普段は停止しておいて Docker が必要なときに起動するようにしている。

最近 Docker Desktop の有償化の話もあったので、 Docker Desktop の代替を検証してみた。

https://www.docker.com/blog/updating-product-subscriptions/