Lecture02 Questions

我没有收到消息提醒,下次你要是发issure,记得先用微信call一下,然后我过来回答 @ShijieGeng

Open ShijieGeng opened 2 years ago

Lecture02 Questions

我没有收到消息提醒,下次你要是发issure,记得先用微信call一下,然后我过来回答 @ShijieGeng

Lecture02 Questions

我没有收到消息提醒,下次你要是发issure,记得先用微信call一下,然后我过来回答 @ShijieGeng

bingo!

Lecture02 Questions

我没有收到消息提醒,下次你要是发issure,记得先用微信call一下,然后我过来回答 @ShijieGeng

bingo!

这次收到了,手机弹出通知提醒了,电脑右下角QQ也弹出提醒.

这次我没提示了┭┮﹏┭┮

这次我没提示了┭┮﹏┭┮

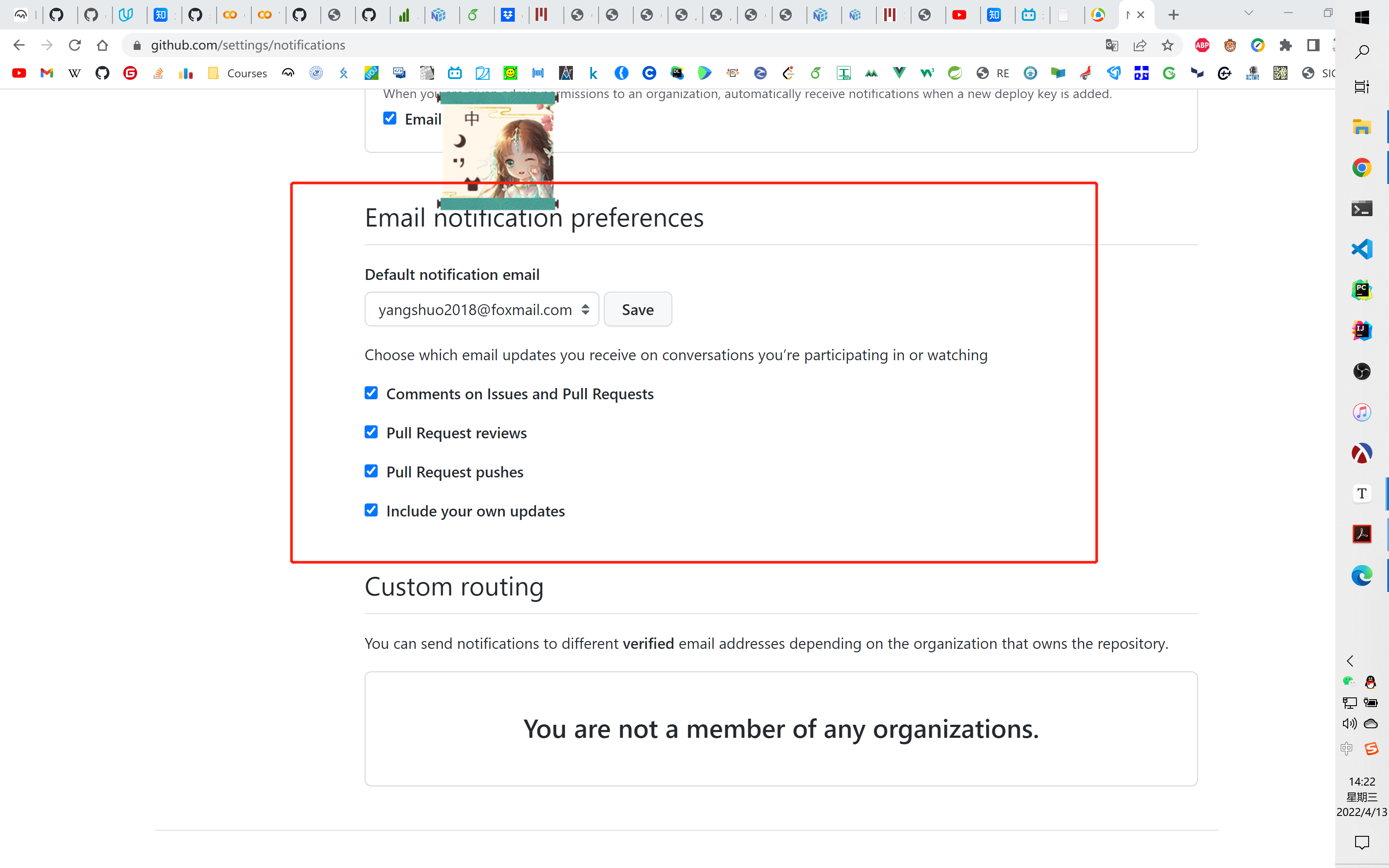

你看一下这个位置的设置:

只要开启,应该是可以提醒的.

只要开启,应该是可以提醒的.

我稍后把我们两人第一节做的笔记整理放到repo里面,也算是当做我们学习的记录了.

这次我没提示了┭┮﹏┭┮

你看一下这个位置的设置:

只要开启,应该是可以提醒的.

我稍后把我们两人第一节做的笔记整理放到repo里面,也算是当做我们学习的记录了.

你一说要整理我那破笔记,就提醒我了ε=(´ο`*)))唉

这次我没提示了┭┮﹏┭┮

你看一下这个位置的设置:

只要开启,应该是可以提醒的. 我稍后把我们两人第一节做的笔记整理放到repo里面,也算是当做我们学习的记录了.

你一说要整理我那破笔记,就提醒我了ε=(´ο`*)))唉

我刚刚花一点时间把这个项目整理了一下,你clone到本地,后面你可以按照我们的计划和约定,创建文件夹来提交你每天的学习笔记记录.如果是笔记记录可以在每周的笔记目录下的Geng文件夹下放置,如何安排由你自行决定.如果当周的学习任务有编程作业,那么我们在当周的文件夹下创建一个名为HM的文件夹,然后在里面创建各自的以各自姓命名的文件夹,在那里放置我们各自的编程作业.我目前初步的想法是这样的,可能使用branch来做这个更好,但是我不会弄.你看看还有那里需要改进的吗?

这次我没提示了┭┮﹏┭┮

你看一下这个位置的设置:

只要开启,应该是可以提醒的. 我稍后把我们两人第一节做的笔记整理放到repo里面,也算是当做我们学习的记录了.

你一说要整理我那破笔记,就提醒我了ε=(´ο`*)))唉

我刚刚花一点时间把这个项目整理了一下,你

clone到本地,后面你可以按照我们的计划和约定,创建文件夹来提交你每天的学习笔记记录.如果是笔记记录可以在每周的笔记目录下的Geng文件夹下放置,如何安排由你自行决定.如果当周的学习任务有编程作业,那么我们在当周的文件夹下创建一个名为HM的文件夹,然后在里面创建各自的以各自姓命名的文件夹,在那里放置我们各自的编程作业.我目前初步的想法是这样的,可能使用branch来做这个更好,但是我不会弄.你看看还有那里需要改进的吗?

哇,是我想象的样子。branch我也不会用,这就已经很好了,慢慢来嘛,如果那个学习进度可以写两个人的,然后对比一下,那岂不是。算了,就这样叭,给我点活路2333。 by the way,issue。

【Class Note1】p5下方,a:=b 和 a=b 的区别是什么, 把变量a 设置为 等于b的值,不就是把 b赋值给a吗

第二个知道了,就是随便给了个函数ε=(´ο`*)))唉

关于那个矩阵求偏导我是这么理解的,$A{21}A{22}$ ,你把这一项看成两个自变量的构成的项,分别对每一项求偏导.

嗯,我觉得就是那样理解的,定义映射$f$ 关于矩阵$A$的导数.

刚刚上面那个issure我没注意到手机的提醒,那时候电脑没登QQ,现在登上去了,应该能随时接收到消息.

第二个知道了,就是随便给了个函数ε=(´ο`*)))唉

是呀,就是给出一个例子,解释上面的求导方法吧

关于那个矩阵求偏导我是这么理解的,$A{21}A{22}$ ,你把这一项看成两个自变量的构成的项,分别对每一项求偏导.

嗯,我觉得就是那样理解的,定义映射$f$ 关于矩阵$A$的导数.

刚刚上面那个

issure我没注意到手机的提醒,那时候电脑没登QQ,现在登上去了,应该能随时接收到消息.

我晓得啦。 没关系,邮件不是即时通信,不用那么着急,当天有空看到解决了就好啦,有啥急问题我会微信直接请教你的呀

这个第一步到第二步,是怎么来的,链式求导?

这个第一步到第二步,是怎么来的,链式求导?

这个第一步到第二步,是怎么来的,链式求导?

嗯,我觉得也是这样,用符合函数链式求导,然后展开对每一项求导

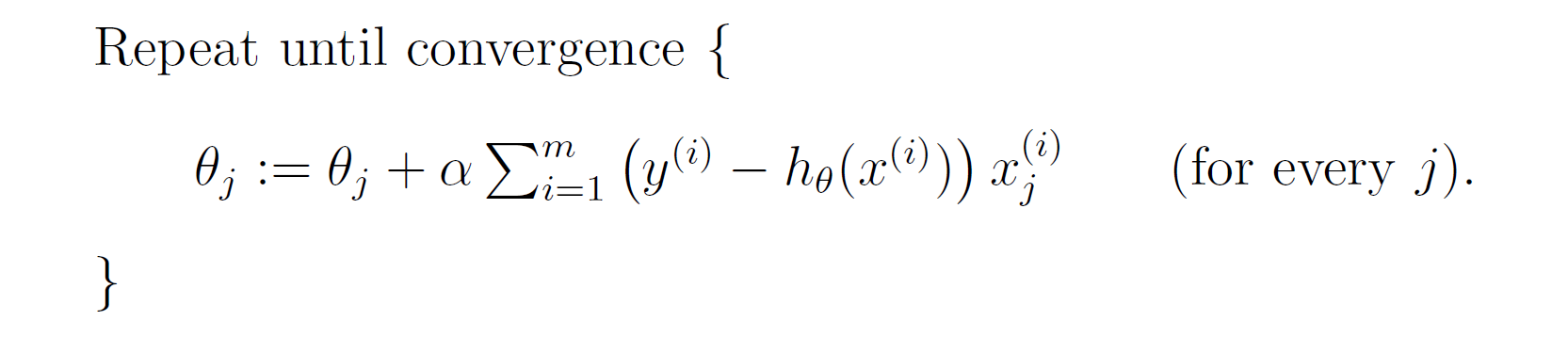

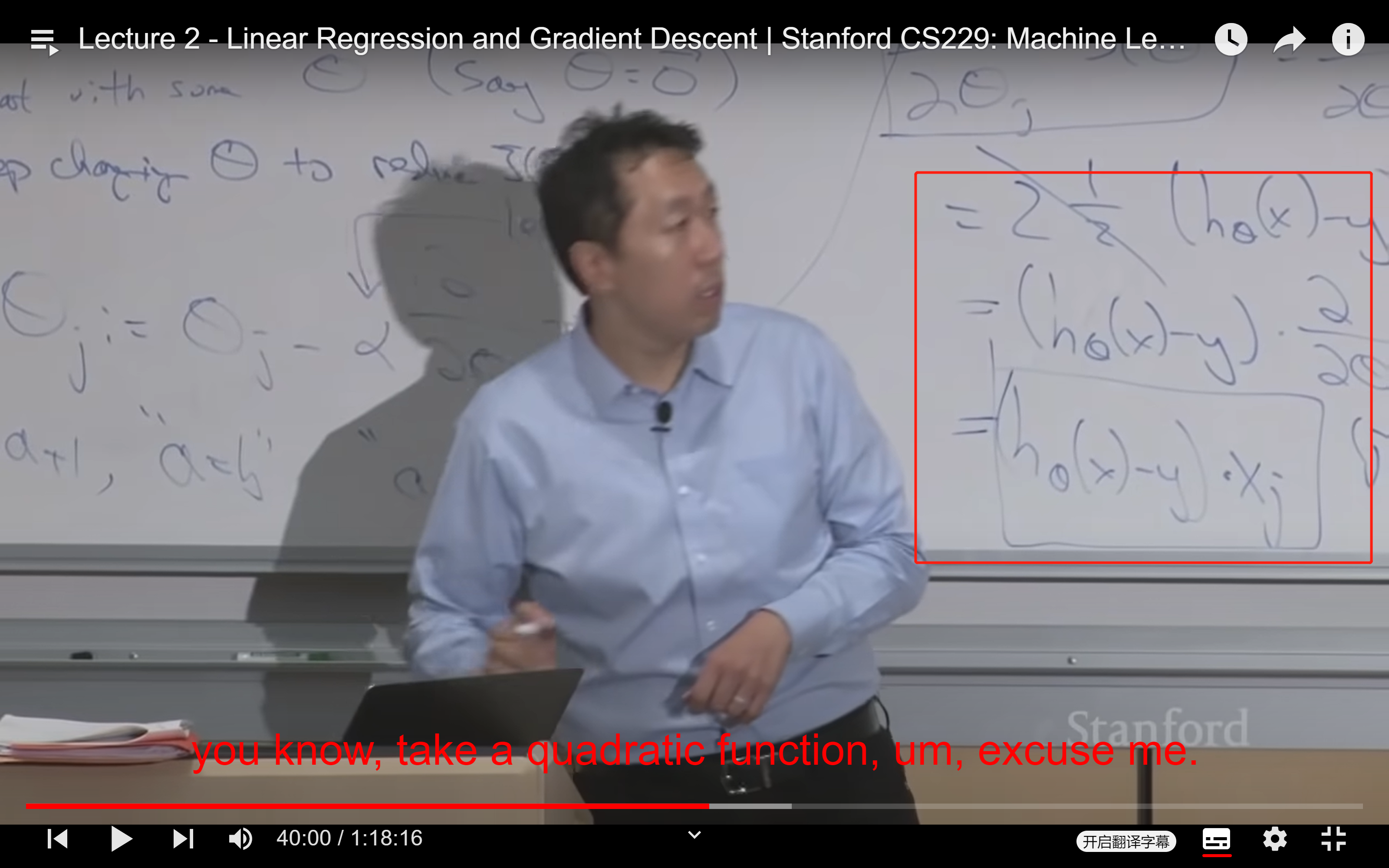

【Video】00:40:00 why are you subtracting Alpha times the gradient rather than adding Alpha times the gradient? Note上的【batch gradient descent】数学公式定义为 θj + α...,而 Ng课上讲的是 θj - α...,这个加和减有什么不同吗? 这是一个学生在课堂上面提的问题,Ng在这个时间解释了,但是没太听懂在说啥(╯▽╰)

【Video】00:40:00 why are you subtracting Alpha times the gradient rather than adding Alpha times the gradient? Note上的【batch gradient descent】数学公式定义为 θj + α...,而 Ng课上讲的是 θj - α...,这个加和减有什么不同吗? 这是一个学生在课堂上面提的问题,Ng在这个时间解释了,但是没太听懂在说啥(╯▽╰)

这个可以截一下图,或者把字幕前后完整的几句话发我吗?我在lecture03没有找到这个

【Video】00:40:00 why are you subtracting Alpha times the gradient rather than adding Alpha times the gradient? Note上的【batch gradient descent】数学公式定义为 θj + α...,而 Ng课上讲的是 θj - α...,这个加和减有什么不同吗? 这是一个学生在课堂上面提的问题,Ng在这个时间解释了,但是没太听懂在说啥(╯▽╰)

这个是notes上面关于梯度下降更新的公式:

这个是Ng上课时候写的关于梯度更新的公式:

我觉得也许问题就是一个是$H{\theta}(x) - y$,另外一个是$y-H{\theta}(x)$,导致这样写的损失函数的梯度恰好是相反的. 我读了半天也没读懂那个学生提的问题是什么意思

【Video】00:40:00 why are you subtracting Alpha times the gradient rather than adding Alpha times the gradient? Note上的【batch gradient descent】数学公式定义为 θj + α...,而 Ng课上讲的是 θj - α...,这个加和减有什么不同吗? 这是一个学生在课堂上面提的问题,Ng在这个时间解释了,但是没太听懂在说啥(╯▽╰)

这个是notes上面关于梯度下降更新的公式:

这个是Ng上课时候写的关于梯度更新的公式:

我觉得也许问题就是一个是$H{\theta}(x) - y$,另外一个是$y-H{\theta}(x)$,导致这样写的损失函数的梯度恰好是相反的. 我读了半天也没读懂那个学生提的问题是什么意思

就是那个公式,note上 是 - ,然后ng上课讲的是 + α...

【Video-Lecture2】01:07:18

对于 这个公式该如何理解?以及证明

对于 这个公式该如何理解?以及证明

【Video】00:40:00 why are you subtracting Alpha times the gradient rather than adding Alpha times the gradient? Note上的【batch gradient descent】数学公式定义为 θj + α...,而 Ng课上讲的是 θj - α...,这个加和减有什么不同吗? 这是一个学生在课堂上面提的问题,Ng在这个时间解释了,但是没太听懂在说啥(╯▽╰)

这个是notes上面关于梯度下降更新的公式:

这个是Ng上课时候写的关于梯度更新的公式:

我觉得也许问题就是一个是$H{\theta}(x) - y$,另外一个是$y-H{\theta}(x)$,导致这样写的损失函数的梯度恰好是相反的. 我读了半天也没读懂那个学生提的问题是什么意思

就是那个公式,note上 是 - ,然后ng上课讲的是 + α...

因为这部分笔记和白板上的损失函数不一样,白板上写的是(H(x)-y)^2,这里是(y-h(x))^2,用链式法则求导后,它们在同一点的梯度方向恰好是相反的,所以对应的更新的方向恰好是相反的,一个就是要接下来要更新的方向,一个是反方向.

【Video-Lecture2】01:07:18

对于 这个公式该如何理解?以及证明

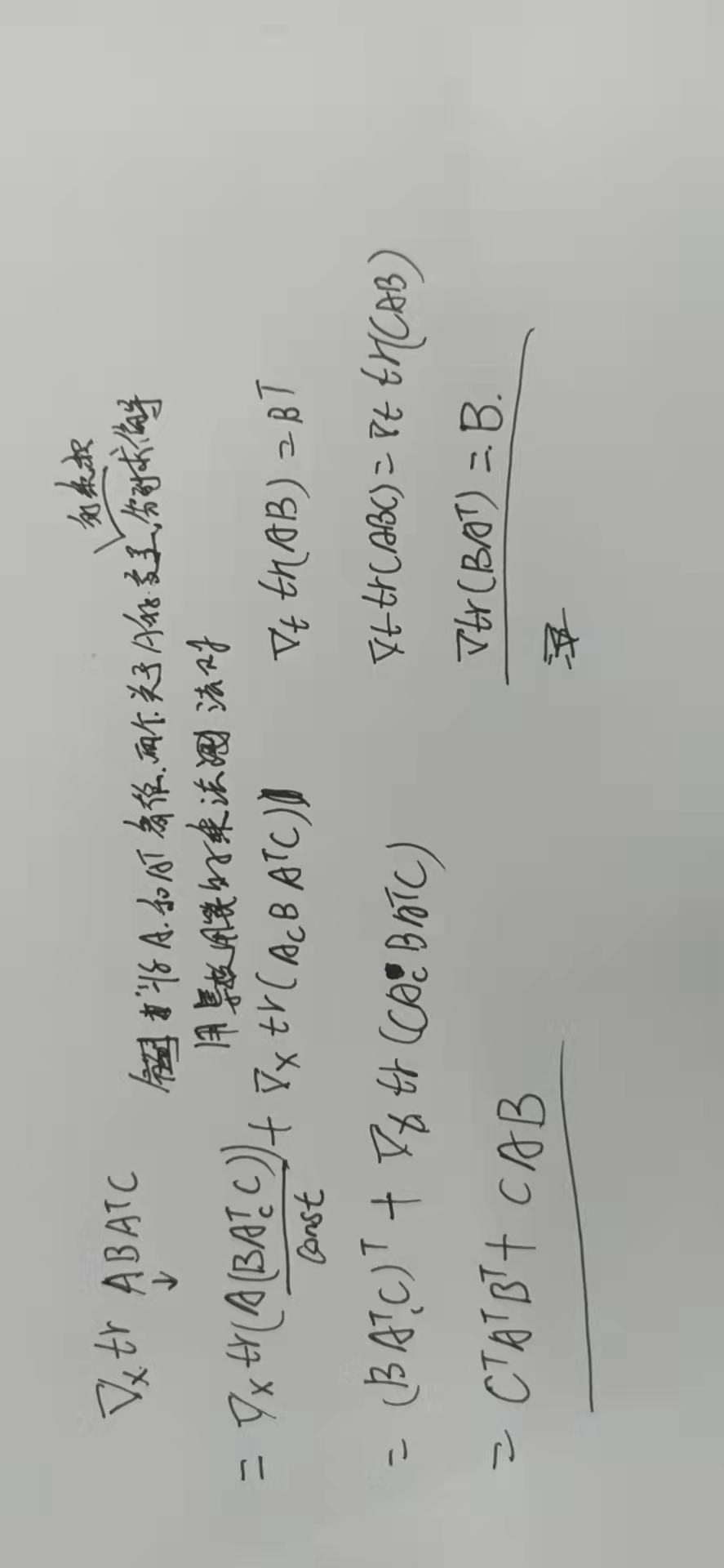

我尝试推导证明,最终得出结论,我太菜了,我当时看了一眼结论就跳过了,然后去网上找了一下证明,找到一个,你可以参考一下,如下图所示,性质6

矩阵求导

【Video-Lecture2】01:07:18

对于 这个公式该如何理解?以及证明

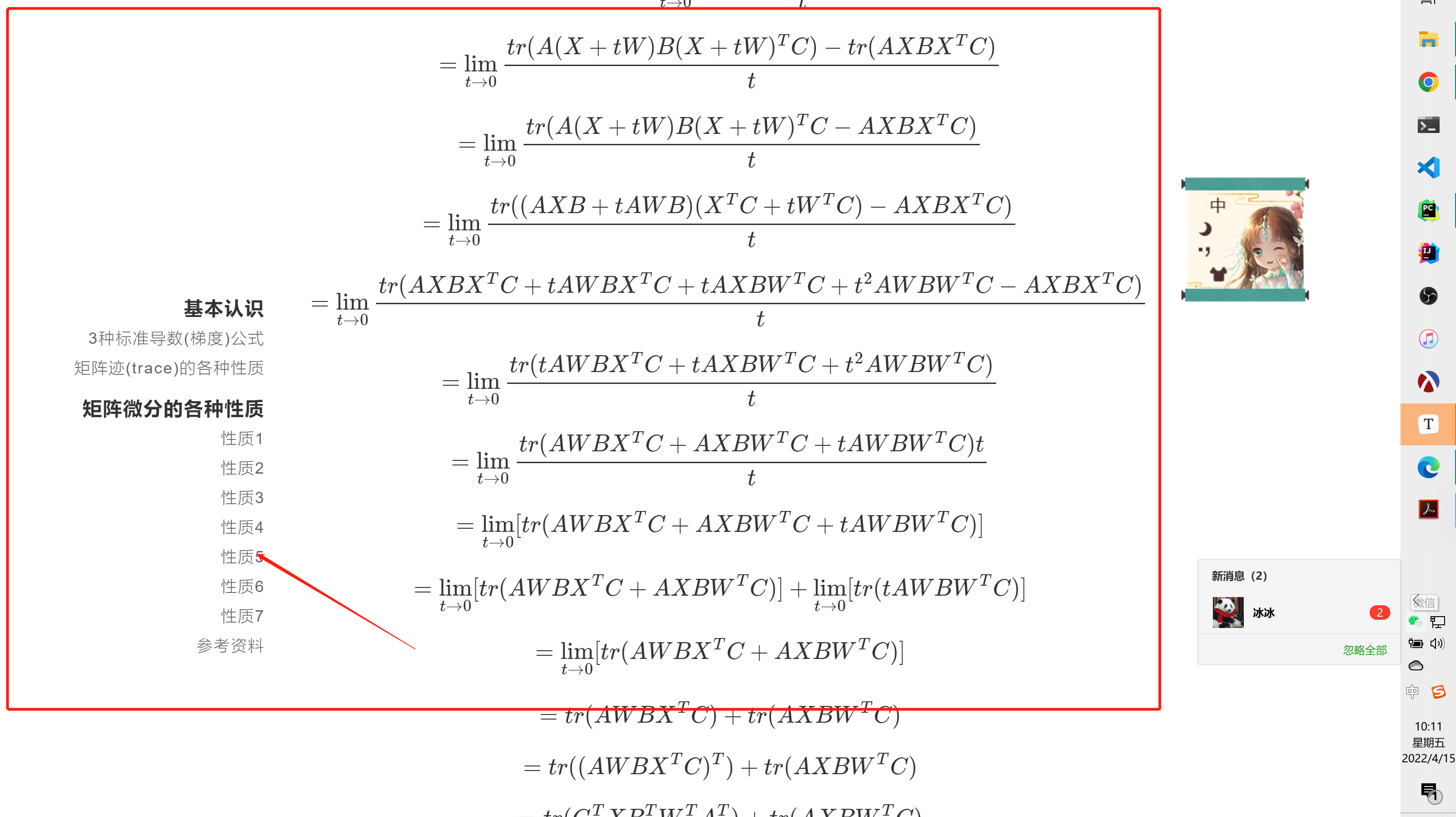

如果不用定义,使用导数运算和trace的性质,这样一个证明或许可以接受:

【Video】00:40:00 why are you subtracting Alpha times the gradient rather than adding Alpha times the gradient? Note上的【batch gradient descent】数学公式定义为 θj + α...,而 Ng课上讲的是 θj - α...,这个加和减有什么不同吗? 这是一个学生在课堂上面提的问题,Ng在这个时间解释了,但是没太听懂在说啥(╯▽╰)

这个是notes上面关于梯度下降更新的公式:

这个是Ng上课时候写的关于梯度更新的公式:

我觉得也许问题就是一个是$H{\theta}(x) - y$,另外一个是$y-H{\theta}(x)$,导致这样写的损失函数的梯度恰好是相反的. 我读了半天也没读懂那个学生提的问题是什么意思

就是那个公式,note上 是 - ,然后ng上课讲的是 + α...

刚刚读某一部分推导时候,我到对你之前提及的一个问题感觉一个的更好的解释:

Lecture02 Questions